Quand on analyse des données mesurées par une variable quantitative continue, les tests statistiques d’estimation et de contraste fréquemment employés se basent sur la supposition qu’on a obtenu un échantillon aléatoire d’une distribution de probabilité de type normal ou de Gauss.

Mais en de nombreuses occasions cette supposition ne s’avère pas valable, et dans d’autres le soupçon qu’elle n’est pas adéquate ne s’avère pas facile à vérifier, pour s’agir d’échantillons petits.

Dans ces cas nous disposons de deux possibles mécanismes:

- Les données peuvent être transformées de telle sorte qu’elles suivent une distribution normale.

- Ou bien il peut faire appel à des tests statistiques qui ne se basent sur aucune supposition quant à la distribution de probabilité à partir de laquelle ont été obtenues les données, et pour cela on les appelle des tests non paramétriques (free distribution), tandis que les tests qui supposent une distribution de probabilité déterminée pour les données s’appellent des tests paramétriques.

1) TESTS NON PARAMÉTRIQUES:

Les tests statistiques non paramétriques sont ceux qui, bien que se basant sur certaines suppositions, ne partent pas de la base que les données analysées adoptent une distribution normale.

Ce sont des techniques statistiques qui ne présupposent aucune distribution de probabilité théorique de la distribution des données.

On appelle tests non paramétriques les tests qui ne présupposent pas une distribution de probabilité pour les données, pour cela elles sont connus aussi comme de distribution libre (free distribution).

Dans la plupart d’entre elles les résultats statistiques dérivent uniquement de procédures d’ordination et de comptage, ce pourquoi sa base logique est de compréhension facile.

Quand nous travaillerons avec des petits échantillons (n < 10) dans lesquelles on suppose que la répartition des données n’est pas normale, il convient d’utiliser des tests non paramétriques, au moins pour corroborer les résultats obtenus à partir de l’utilisation de la théorie basée sur la normalité.

Dans ces cas on emploie comme paramètre de centralisation la médiane, qui le point pour lequel la valeur de X es dans 50% des cas en-dessous et dans 50% des cas au dessus.

Les tests non paramétriques ne requièrent pas d’assumer la normalité de la population et dans sa majorité se basent sur l’ordre des les données, la population doit être continue.

Le paramètre qui est utilisé les tests statistiques est la médiane et non la moyenne.

Ce sont des techniques statistiques qui ne présupposent aucun modèle probabilistique théorique.

Ils sont moins puissants que les tests paramétriques, bien qu’ils présentent l’avantage de pouvoir s’appliquer plus facilement.

2) TESTS PARAMÉTRIQUES:

Les tests statistiques paramétriques, comme la « t » de Student ou de l’analyse de variance (ANOVA), se basent sur la supposition d’une forme déterminée de distribution de valeurs, généralement la distribution est normale, dans la population dont on obtient l’échantillon expérimentale.

En opposition avec les tests non paramétriques, les tests paramétriques si présupposent une distribution théorique de probabilité sous-jacente pour la distribution des données.

Ils sont plus puissants que les tests non paramétriques.

Dans les tests paramétriques, les plus habituelles se basent sur la distribution de probabilité normale, et en estimant les paramètres du modèle on suppose que les données constituent un échantillon aléatoire de cette distribution, ce pourquoi l’élection du comparateur et le calcul de précision l’estimation, les éléments de base pour construire des intervalles de confiance et de contraste de l’hypothèse, dépendent du modèle probabilistique supposé.

Quand une procédure statistique sera peu sensible à des altérations dans le modèle probabilistique supposé, cela veut dire que les résultats obtenus sont approximativement valables quand celle-ci varie, on dit que c’est une procédure robuste.

3) ANALYSES DE LA VARIANCE (ANOVA)

ANOVA sont des sigles pour l’analyse de la Variation (ANalysis Of VAriance).

Un ANOVA produit diverses sources de la variation vue dans des résultats expérimentaux.

C’est un ensemble de techniques statistiques qui permet de savoir de quelle manière la valeur moyen d’une variable est affectée par différents types de classifications des données.

Avec l’analyse de la variance on peut adapter les estimations de l’effet d’un traitement selon d’autres facteurs comme sexe, âge, gravité, etc.

C’est une technique statistique qui sert à décider/déterminer si les différences qui existent entre les moyennes de trois groupes ou plus (niveaux de classification) sont statistiquement significatives.

Les techniques d’ANOVA se basent sur la partition de la variance pour établir si la variance expliquée par les groupes formés est suffisamment plus grande que la variance résiduelle ou non expliquée.

L’analyse de la variance (ANOVA) est une technique statistique de contraste d’hypothèse.

Traditionnellement ces techniques, conjointement avec les techniques de régression linéaire multiple, dont elles sont pratiquement une extension naturelle, marquent le début des techniques multivariantes.

Avec ces techniques on manie simultanément plus de deux variables, et la complexité de l’appareil mathématique est proportionnellement augmentée avec le nombre de variables en jeu.

L’analyse de variance d’un facteur est le modèle le plus simple : une seule variable nominale indépendante, avec trois niveaux ou plus, explique une variable dépendante continue.

Une autre alternative, qui est apparentement plus logique et intuitive, consiste à comparer, dans toutes les possibles combinaisons de deux en deux, les moyennes de tous les sous-groupes formés.

Dans l’ANOVA on compare des moyennes, pas des variances : moyennes des sous-groupes ou strates dues aux facteurs de classification étudiés.

Un ANOVA alors étudie si la variation associée à une source expliquée est grande para rapport à la variation inexpliquée.

Si ce quotient (la statistique de F) est tellement grand que la probabilité que l’événement s’est produit par hasard est basse (par exemple, P<=0.05), nous pouvons conclure (dans ce niveau de probabilité) que cette source de la variation avait un effet significatif.

CONDITIONS GÉNÉRALES D’APLICACIÔN.

A – INDÉPENDANCE DES ERREURS I

Les erreurs expérimentales doivent être indépendantes. Elle s’obtienne si les sujets sont assignés aléatoirement. C’est-à-dire, que l’on obtient cette condition si les éléments des divers groupes ont été choisis par échantillonnage aléatoire.

B – NORMALITÉ

On suppose que les erreurs expérimentales sont distribuées normalement. Ce qui suppose que chacune des ponctuations yi.i sera normalement distribuée.

Pour le vérifier on peut appliquer un test d’ajustement de la distribution normal comme le test de Kolmogov-Smirnov.

C – HOMOGÉNÉITÉ DE VARIANCES.

La variance des sous-groupes doit être homogène σ21 = σ22 = ….. = σ2k puisqu’ils sont dus à l’erreur. Ils seront vérifiés au moyen du test de : Raison de variances (max. /min), C de Cochran, Barlett-Box…

4) ANALYSES DE LA COVARIANZA (ANCOVA)

Méthode d’analyse statistique qui est une extension de l’analyse de la variance, qui permet d’adapter les estimateurs de l’effet d’un traitement selon de possibles covariables et facteurs.

C’est une technique statistique qui combine ANOVA (parce qu’elle compare des moyennes entre des groupes) et analyse de régression (adapte les comparaisons des moyennes entres les groupes par des variables continues ou covariables)

5) ANALYSES DE RÉGRESSION

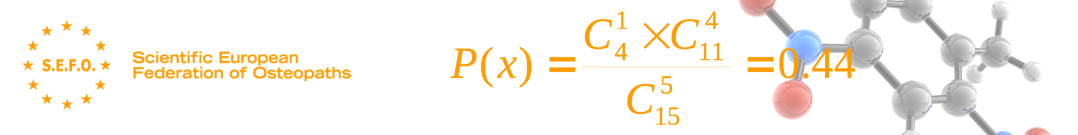

![]() Dans un ensemble de données sur la variable dépendante et sur une ou plusieurs indépendants variables, , elle consiste à déterminer le modèle mathématique le plus adapté qui décrit et comme une fonction de x ou pour prédire et à partir de x.

Dans un ensemble de données sur la variable dépendante et sur une ou plusieurs indépendants variables, , elle consiste à déterminer le modèle mathématique le plus adapté qui décrit et comme une fonction de x ou pour prédire et à partir de x.

Les types les plus courants sont le modèle linéaire et le modèle logistique.

6) ANALYSES PAR PROTOCOLE

Dans une étude clinique, l’analyse des données selon le traitement choisi, en opposition avec l’analyse de l’intention de traiter, qui est effectué selon le traitement assigné dans le processus d’assignation aléatoire. L’analyse par protocole tend à mesurer l’efficacité de l’intervention, pour l’évaluation de laquelle il convient d’inclure seulement les patients qui ont été réellement exposés aux traitements prévus.